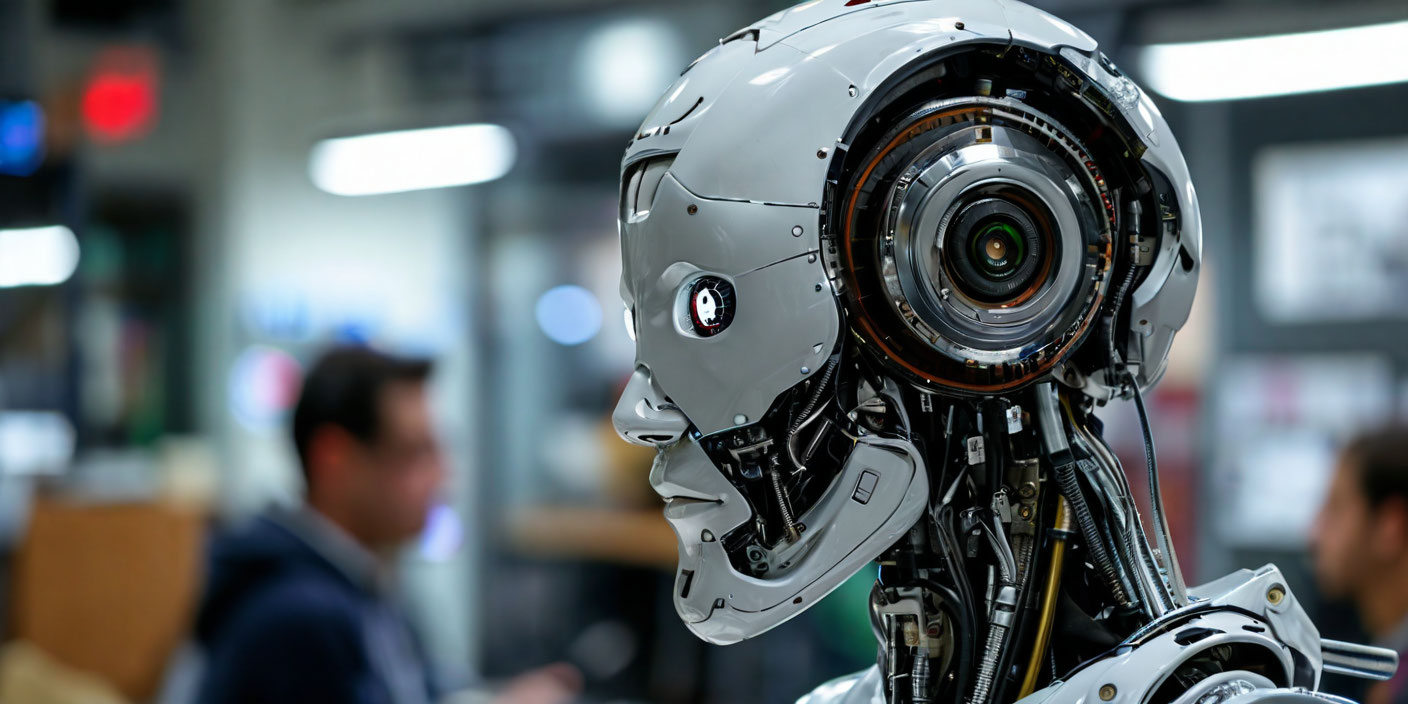

Опасности обучения ИИ на непроверенных данных.

Специалисты Нью-Йоркского университета в США описали потенциальную опасность, связанную с обучением моделей искусственного интеллекта на непроверенных данных.

Исследование было опубликовано в журнале Nature. По словам учёных, большие языковые модели искусственного интеллекта могут ошибаться, если их обучать на фейковой информации или специально загружать антинаучные данные.

Исследователи выяснили, что даже при небольшом уровне дезинформации в обучающих материалах, всего 0,001 процента, нейросети могут выдавать значительное количество неверных ответов. Для проверки влияния дезинформации на процесс обучения учёные использовали модель GPT 3.

5. Они обучили две большие языковые модели на медицинской базе данных The Pile, выбрав 20 тем из трёх медицинских областей: общая медицина, нейрохирургия и лекарства.

Оказалось, что нейросети не только транслируют неверную информацию по прямым запросам, но и начинают ошибаться в смежных темах. Учёные заявили, что это открывает возможности для манипуляций с искусственным интеллектом.

Например, при показателе дезинформации в 0,01 процента большая языковая модель начинает ошибаться в 10 процентах ответов. Если снизить количество фейковых обучающих материалов на порядок — до 0,001 процента, то модель начинает делать ошибки в 7 процентах случаев.

Учёные также отметили, что люди склонны получать информацию от чат-ботов и не проверять её с помощью специалистов. Поэтому они подчеркнули важность подтверждения данных, которые используются для обучения моделей.

В начале января специалисты Bloomberg Intelligence сообщили, что в течение ближайших трёх-пяти лет крупнейшие банки сократят до 200 тысяч сотрудников из-за распространения искусственного интеллекта. Четверть респондентов прогнозируют сокращение пяти-десяти процентов общей численности персонала.